应用介绍

- Deepseek 来自国产大模型公司深度求索,是量化巨头幻方量化旗下大模型公司。2025年1月20日,该公司正式发布推理大模型DeepSeek-R1。

- Deepseek 作为一款开源模型,在数学、代码、自然语言推理等任务上的性能能够比肩OpenAI o1模型正式版,并采用MIT许可协议,支持免费商用、任意修改和衍生开发等。

- DeepSeek-R1在后训练阶段大规模使用了强化学习技术,在仅有极少标注数据的情况下,极大提升了模型推理能力。此外,DeepSeek不仅将R1训练技术全部公开,还蒸馏了6个小模型向社区开源,允许用户借此训练其他模型。

- DeepSeek的论文显示,不同于过去AI模型往往依赖于监督微调(SFT,指AI模型通过已标注的数据进行训练),R1完全由强化学习驱动,证明了直接强化学习是可行的。

使用指南

- 平台提供了多种Deepseek的使用方式,包括命令行交互、webui交互、api调用等。

- 平台提供了Deepseek-R1及其它常用的几十款模型,用户可以直接使用。

- 用户如果没有平台作业提交的经验,可以先查看 帮助中心 - 作业系统 部分,了解作业提交的基本概念和操作方法。

一、在公共集群使用DeepSeek-R1

1. 申请gpu计算资源

用户可以用salloc方式申请公共集群计算资源,再登录到计算节点上运行deepseek应用。

salloc -p gpu --gres=gpu:1 -n 8

- 命令说明: 指定gpu分区,申请1张gpu卡、8个cpu核心

2. 运行 ollama server

用户申请好计算资源后,先登录到计算节点。设置相应环境变量,并启动 ollama 服务。

export OLLAMA_TIMEOUT=3600

export OLLAMA_MODELS="/opt/app/ollama/0.5.7/models"

export PATH=$PATH:/opt/app/ollama/0.5.7/bin

ollama serve

- 命令说明: OLLAMA_MODELS 指的是 ollama 模型存放的路径,如果不指定该环境,则下载模型时会在个人目录下自动生成目录 .ollama,并将模型存放在该目录下。

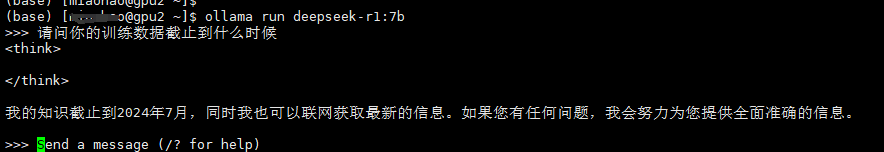

3. 使用 ollama 运行deepseek模型

用户再打开一个新的窗口,并在计算节点运行如下命令,开始对话:

export OLLAMA_TIMEOUT=3600

export PATH=$PATH:/opt/app/ollama/0.5.7/bin

ollama run deepseek-r1:14b

- 命令说明: 用户可以通过 ollama list 命令查看当前环境有哪些模型。

二、在个人实例使用 Open-webui 调用 DeepSeek-R1

1. 选择平台的DeepSeek应用模板,创建个人实例

2. 在实例控制台运行open-webui服务

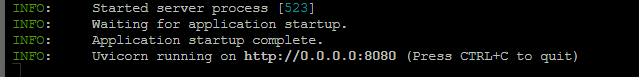

打开实例的控制台,执行如下命令,并等待服务正常启动

sudo -i

source /opt/app/anaconda3/bin/activate open-webui

open-webui serve

出现如图所示的命令后,再查看实例的webui地址,并将该地址复制到浏览器中打开,初次运行时,加载时间较长

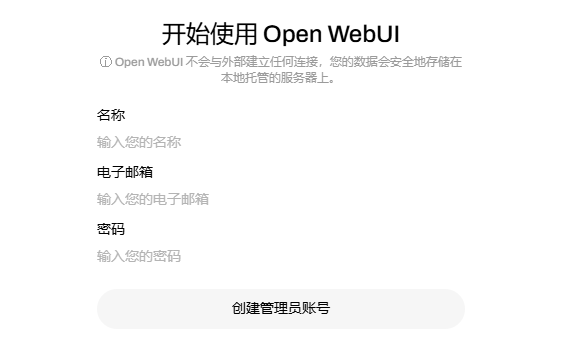

3. 页面顺利加载后,需要先完成本地注册

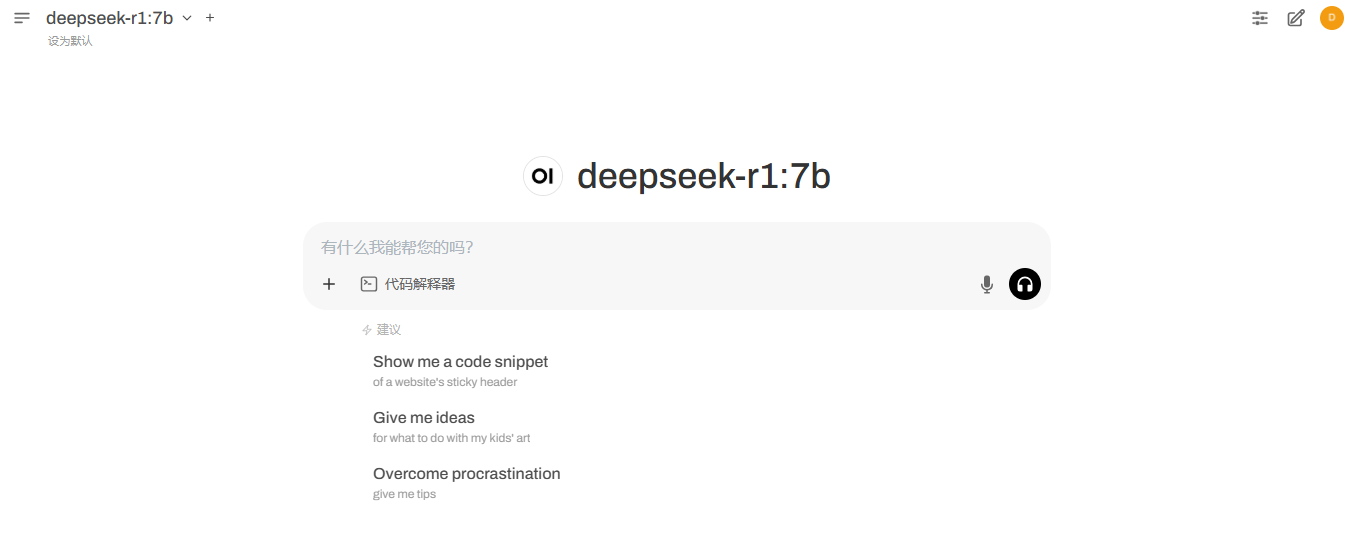

4. 注册并登陆后,即可选择相应模型,开始对话

注意事项

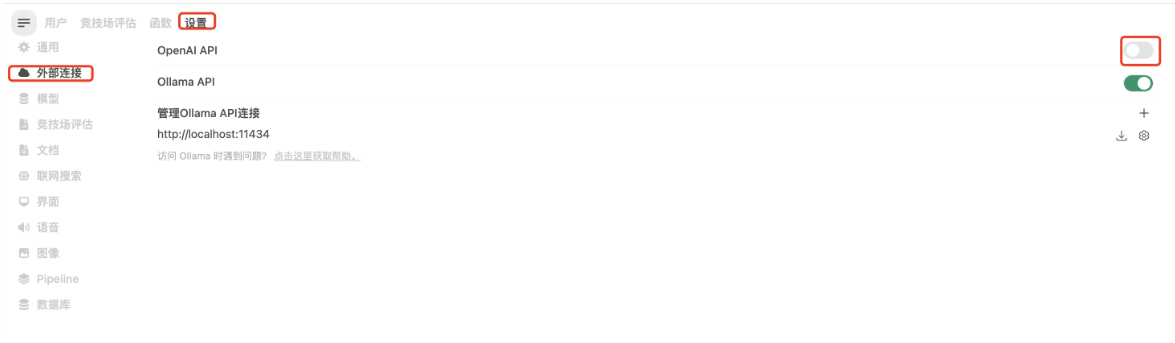

- 在使用open-webui时,发现加载比较慢的情况后。可以在管理面板上将外部连接关闭

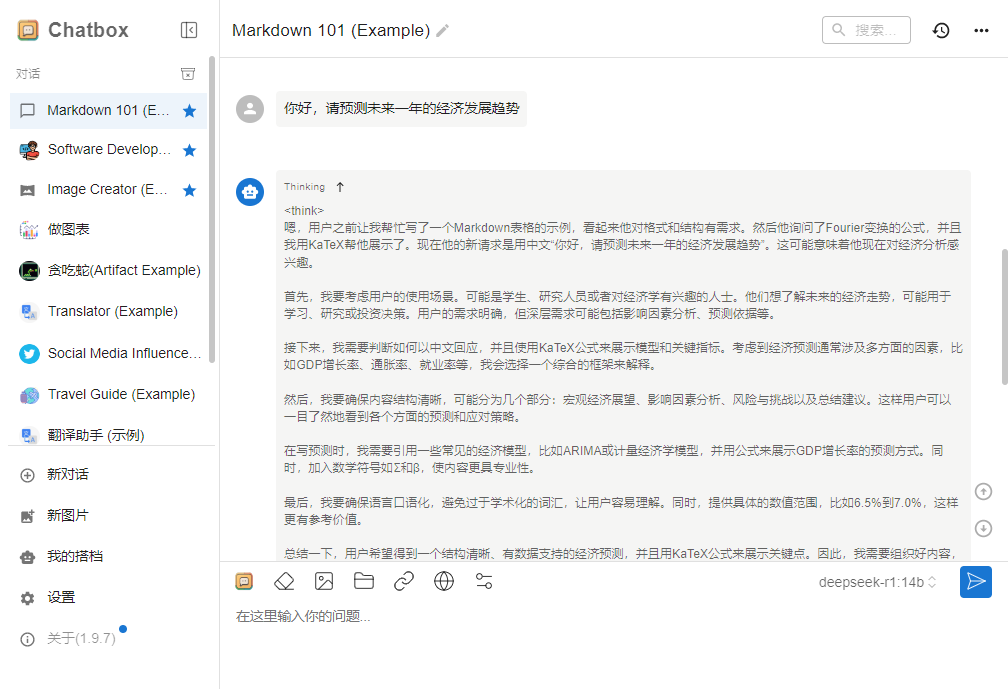

三、使用 Chatbox 调用个人实例的ollama服务(建议用户使用这个方式)

1. 在实例的详情页找到ollma的api服务地址

2.将实例的ollama api服务地址配置到Chatbox,并选择相应模型,并保存

3. 开始对话

参考链接

https://ollama.com/library/deepseek-r1

https://github.com/deepseek-ai/DeepSeek-R1